GPT训练原理,15分钟全文理解

①、GPT引发全球热议,看得懂的科普解读

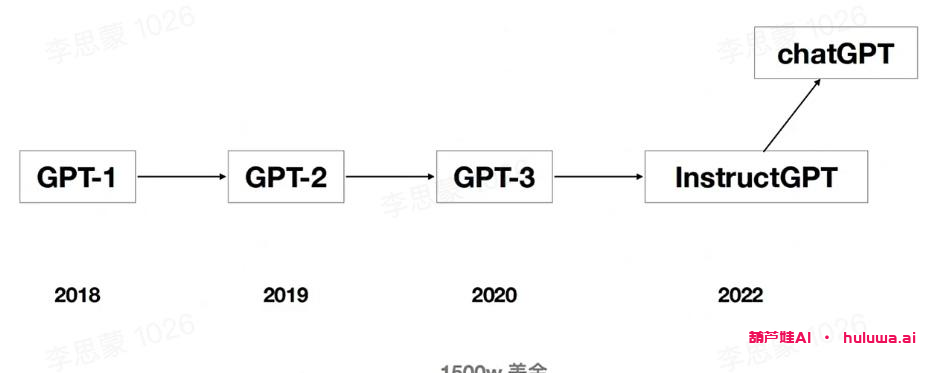

GPT是一款备受瞩目的AI模型,不仅仅在AI领域引起了轰动,还吸引了普通大众的关注👏。作为GPT-3.5的预热模型,它与去年发布的InstructGPT是姐妹模型,被人们亲切地称为GPT-3.5。据传,即将发布的GPT-4将是一个多模态模型,不仅能理解文本,还能处理视频、图片和语音等多种形式的输入,让对话内容更加生动有趣。

GPT和InstructGPT在模型结构和训练方式上完全一致。它们都采用了指令学习和基于人工反馈的强化学习方法进行训练,只是在数据采集方式上有所不同🔝。虽然GPT的论文和代码细节尚未公布,但我们可以通过InstructGPT来理解GPT的模型和训练细节。

②、GPT的训练步骤:SFT、RM、PPO

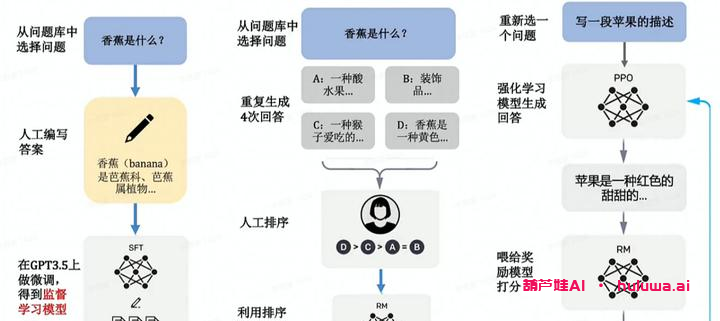

GPT的训练可以分成三个主要步骤:SFT、RM和PPO。

-

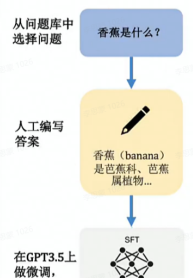

SFT(Supervised FineTune)是实现对话的第一步。对话模型的训练离不开SFT,即对GPT-3进行有监督微调。SFT的目的是优化数据集,利用人类喜欢的答案作为训练数据,让机器生成更符合人类喜好的内容。

-

RM(Reinforcement Learning)是强化学习的步骤,用于评估模型生成的内容的好坏🔥。通过RM,模型可以得到内容的质量反馈,而不仅仅是告诉模型如何变得更好。这种方式能够让模型更自由地探索,训练出更具有泛化能力的模型。

-

PPO(Proximal Policy Optimization)是最后的微调步骤。在这一阶段,我们将前面训练好的SFT和RM模型结合起来,利用PPO算法微调生成模型。生成的答案将被送入RM模型进行评分,并基于RM的损失函数迭代生成模型。

GPT的训练过程中,结合了强化学习和预训练模型,这是近年来最热门的AI研究方向之一。之前有科研工作者认为强化学习难以应用到预训练模型中,因为很难通过模型的输出内容建立奖励机制。而InstructGPT/GPT成功地实现了这一点,通过人工标注和强化学习相结合,将强化学习引入到预训练语言模型中,这是该算法的最大创新之处。

要点

GPT是一款备受瞩目的AI模型,与InstructGPT相似,它采用指令学习和基于人工反馈的强化学习来进行训练。通过SFT、RM和PPO三个步骤,GPT能够生成更符合人类喜好的内容,具有较高的泛化能力。GPT的训练过程结合了强化学习和预训练模型,成功地实现了这两个领域的结合,带来了令人惊叹的效果。

感谢您的阅读💯!

想要了解更多相关信息,请点击链接访问葫芦娃AI

暂无评论内容